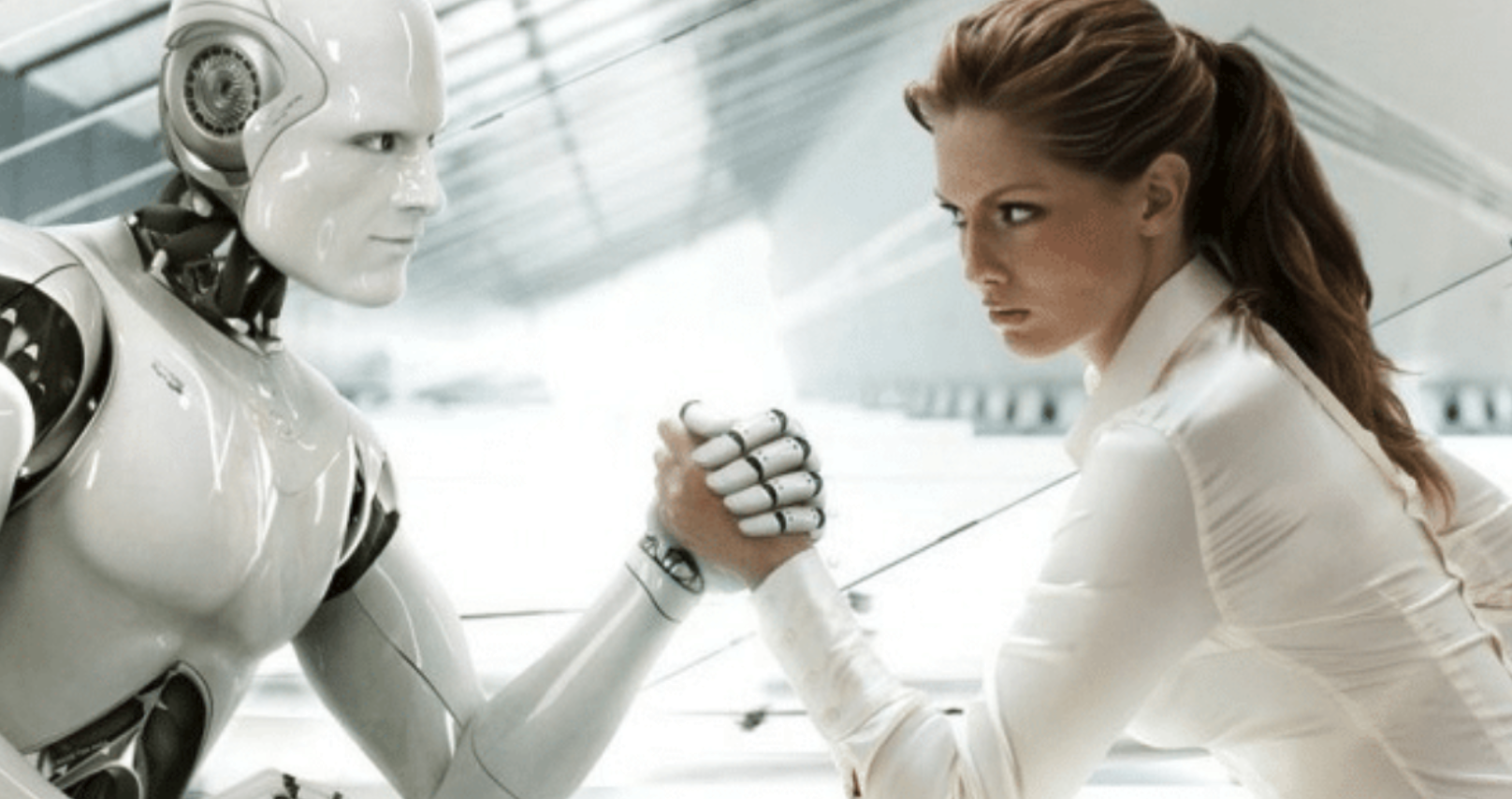

Людству загрожує загибель через штучний інтелект. Імовірність – 95%

Людству загрожує загибель через штучний інтелект. Імовірність – 95%

Загибель всього людства через розвиток штучного інтелекту - за підрахунками експертів ймовірність трагедії досягає 95%

За словами нобелівського лауреата та кількох дослідників, надрозумні боти дійсно здатні стерти нас із Землі. На думку експертів, машинний інтелект зрівняється із людським буквально протягом року.

Похмурим днем наприкінці липня приблизно 25 людей зібралися перед несмачним фасадом офісу OpenAI у районі Мішн-Бей. На кожному з них була одягнена червона футболка зі словами: "Стоп ІІ" — це їхнє головне гасло, а заразом і назва всієї протестної групи. Один із протестувальників був одягнений, як робот.

Політичний протест глибоко вкоренився у культурі міста Сан-Франциско. Протестувальники на цьому мітингу схожі на тисячі інших активістів, які виступають проти, здавалося б, містечкових проблем. Більшість людей, дивлячись на такі вуличні демонстрації, просто знизує плечима і йде у свої справи.

Але, якщо ці протестувальники в червоних футболках хоча б трохи мають рацію, то кожна людина на нашій планеті має бути з ними солідарною. Адже активісти руху "Стоп ІІ" заявляють, що людство приречене на вимирання, якщо ми продовжимо розвивати існуючі технології штучного інтелекту за нинішніх темпів.

З активістами погоджується кількість експертів, що тривожно зростає.

У тому числі:

● Нобелівську премію з фізики, що отримав у 2024 році за роботи в галузі штучного інтелекту вчений Джеффрі Хінтон;

● лауреат премії Тьюринга, канадський математик, кібернетик та спеціаліст з машинного навчання Йошуа Бенджіо;

● керівники OpenAI, Anthropic та Google DeepMind.

Усі вищеперелічені особи нещодавно підписали відкритий лист, де, серед іншого, прозвучала ключова теза: "Не допустити вимирання людства на тлі розвитку штучного інтелекту — ось те завдання, що має стати нашим глобальним пріоритетом. Ми повинні оцінювати її так само серйозно, як і інші ризики планетарного масштабу, чи то пандемія".

Варіантів, як може статися, експерти перераховують чимало. Один із сценаріїв говорить: "навчена система ІІ випускає дюжину снарядів з біологічною зброєю всередині. Боєголовки з токсичним спреєм непомітно розсилають по великих світових столицях, що дозволить миттєво поширити вірус по всьому світу". Конкретні деталі, як це відбуватиметься, вже не є важливими. Для будь-якої надрозумної ІІ-моделі людина - прямий конкурент, а значить, стерти нас з лиця Землі не важко. А головне — це стане його першочерговим завданням.

За словами колишнього інженера-розробника Google і Microsoft, а нині президента Інституту досліджень машинного інтелекту Нейта Соареша, ймовірність нашого вимирання через штучний інтелект становить "щонайменше 95 відсотків", якщо ми продовжимо розвивати ІІ в тому ж темпі. Вчений порівняв поточну ситуацію з автомобілем, який на швидкості 160 кілометрів на годину мчить до краю урвища. "Я не кажу, що ми з вами не зможемо зупинити цю машину, - розмірковує про проблему Соареш. - Просто це не скасовує факту, що ми, як і раніше, мчимо до обриву на шаленій швидкості".

Шлях до вимирання

На сьогоднішній день штучний інтелект перебуває у своїй початковій стадії розвитку. Ми всі користуємося його технологіями, коли, наприклад, підключаємо робота для вирішення вузькоспрямованих когнітивних завдань. До них відносяться вже звичні обивателю сортування даних в електронній таблиці або автовідповідач на e-mail. Таку технологію називають "вузьким", або "слабким ІІ" (Narrow AI).

Однак найближчим часом все ризикує змінитись. Не має значення, про які терміни йдеться, — рік, кілька років чи десятиліття. Рано чи пізно технології досягнуть рівня загального штучного інтелекту – ОІІ (AGI). Ця абревіатура означає стадію, де ІІ буде об'єктивно порівняний з людським розумом.

Щойно етап ОІІ стане реальним, технологічні можливості штучного інтелекту перестануть бути чимось обмеженим. Замість одного вузькоспрямованого завдання система зможе брати участь у плануванні складних процесів, розраховувати ймовірні результати та давати їм оцінку в різних галузях.

У технологій ІІ буде набагато більше переваг перед живими людьми. Їм не потрібно буде спати або робити перерви на їду. Їм також не доведеться витрачати довгі роки на навчання, щоб досягти майстерності. Вони просто передадуть свої знання та навички наступному поколінню штучного інтелекту. Іншими словами, вони просто "скопіюють і вставлять" весь напрацьований досвід.

Фінальною стадією розвитку стане штучний суперінтелект - ІСІ (SAI). Він буде здатний робити те, про що людство не могло і мріяти: лікувати рак, освоювати холодний ядерний синтез чи мандрувати до далеких зірок. Технології перетворяться на свого роду цифрових богів.

Таку утопію нам просувають люди, які називають себе ІІ-ентузіастами. Але будь-яка утопічна ідея ґрунтується на принципі, коли штучно створений "бог" беззастережно підкоряється будь-яким вашим наказам. Як виявилося, досягти цього від цифрової системи — неймовірно складне з технічного погляду завдання, яке дослідники нейромереж назвали "узгодженням".

На сьогоднішній день досягти повного узгодження, а простіше кажучи, контролю за штучним інтелектом практично нереально. Причина проста: нам потрібно з точністю передбачити кожен крок, про що подумає ІСІ у тій чи іншій задачі. Це схоже на спробу передбачити логіку дій надрозумної інопланетної раси. Допустимо, ми здатні наказати ІІ, що потрібно зробити. Проте людський мозок неспроможна відстежити хід подальших рішень. І найголовніше, цифрові системи вміють нам брехати; на даному етапі розвитку вони роблять це постійно. Навіть слабкий ІІ, не кажучи вже про майбутнє ІСІ, легко обманює людину. Уміння працювати із довгостроковим плануванням автоматично підключає механізм брехні. Бот зможе переконати нас, що він на нашому боці, хоч насправді це не так.

І правду ми ніколи не зможемо дізнатися. Багато внутрішніх процесів прийняття рішень в ІІ вже незбагненні для людей. "Можна створювати інтелектуальні комп'ютери, не маючи ні найменшого уявлення про те, з чим ти, чорт забирай, працюєш, - продовжує Соареш. - Ми беремо нереальну обчислювальну потужність і обрушуємо її на воістину колосальний обсяг даних. В результаті виходить те, що ми за звичкою називаємо комп'ютером. А ось що. Експерт додає, що рано чи пізно ІСІ почнуть спілкуватися між собою абсолютно новою мовою, яку створить людина.

Можливо, щось уже почало відбуватися. Штучний інтелект, схоже, розвиває "дивні" уподобання та шукає приховані способи їх реалізації. Генеративний чат-бот Grok, випущений Ілоном Маском, нещодавно прогримів на весь світ своїми антисемітськими постами та звеличенням Гітлера. Трохи згодом розумний помічник Bing ледь не зруйнував шлюб журналістки The New York Times.

"Ми вже бачимо перші ознаки небезпеки, - робить висновок Соареш. - Якщо ці чат-боти зроблять стануть надто розумними, результат буде дуже негарним".

"Людство, що живе на сміттєзвалищі"

Виконавчий директор PauseAI Холлі Елмор не поділяє радикального погляду Соареша. На її думку, замість 95 ймовірнішим шансом на вимирання людства є показник 15–20 відсотків. Розрахунки сценарію p(doom) від провідних інженерів, включаючи команду Ілона Маска, наводять у своїх дослідженнях приблизно такі самі цифри. Генеральний директор Google Сундар Піча оцінює ймовірність на рівні десяти відсотків. Ці прогнози вважаються оптимістичними.

Але навіть без тотального вимирання людей, вважає Елмор, ІІ катастрофічно погіршить наше життя. "Це загроза самовизначенню людства", - сказала вона.

Її тривога перегукується з побоюваннями, викладеними у статті під назвою "Поступове позбавлення прав та можливостей", написаної фахівцями зі штучного інтелекту з кількох університетів та аналітичних центрів. У статті прогнозують ризики заміни людини на високорозвинені машини.

"Уявіть собі ситуацію, коли всі люди фактично живуть на звалищах, - сказала співзасновник дослідницької групи AI Impacts Катя Грейс. - У нас не було б жодної політичної чи економічної влади, ми не змогли б зрозуміти, що відбувається навколо. І це вже відбувається набагато швидше, ніж ми встигаємо усвідомити".

Холлі Елмор вважає, що слід призупинити розробку ІІ, доки ми не врахуємо всі ризики. Для цього буде потрібна якась міжнародна угода, сказала вона. Експерт планує переїхати до Сакраменто, щоб розпочати розробку законопроекту, який обмежує впровадження штучного інтелекту. На сьогоднішній день штат Каліфорнія – світовий лідер з машинного навчання.

Політики рухаються у протилежному напрямку. У червні адміністрація Дональда Трампа оголосила про план дерегулювання досліджень у галузі штучного інтелекту. У Сан-Франциско такі компанії, як OpenAI та Anthropic, активно просуваються вперед. Марк Цукерберг нещодавно заявив, що надрозумний штучний інтелект "вже на горизонті". Щоб прискорити його появу, медіамагнат активно переманює на свій бік найкращих фахівців із OpenAI, обіцяючи їм премії на загальну суму 100 мільйонів доларів.

Холлі Елмор підсумувала, що ІІ-ентузіасти не пручаються розвитку технологій і не ставлять її на паузу, скоріше, з політичних та ідеологічних причин. Для деяких із них штучний інтелект став новітньою формою релігії. Один із прихильників просування нейромереж якось на повному серйозі заявив їй, що він ніколи не помре, тому що "ІСІ обезсмертить його свідомість".

Для таких людей зречення штучного інтелекту означає відмову від вічного життя. "Вони впевнені, що зможуть знайти свій рай", - додає Елмор. І ніхто вже не прислухається до вчених, які попереджають, що пекло тут набагато ближче.

The Times , Великобританія

У Миколаєві пролунав вибух: над містом збили «шахед» (відео)

У Миколаєві пролунав вибух: над містом збили «шахед» (відео) Вибухи у Миколаєві: над містом шахеди, працює ППО (відео)

Вибухи у Миколаєві: над містом шахеди, працює ППО (відео) Комунальними розкопками вбито дорогу в центрі Миколаєва: що говорять у міськраді (відео)

Комунальними розкопками вбито дорогу в центрі Миколаєва: що говорять у міськраді (відео) Останній день зими: у Миколаєві квітнуть проліски (фото, відео)

Останній день зими: у Миколаєві квітнуть проліски (фото, відео) Знеструмлений трамвай перекрив рух на проспекті в Миколаєві: утворилися затори (відео)

Знеструмлений трамвай перекрив рух на проспекті в Миколаєві: утворилися затори (відео) На Південному Бузі пожежа – горять зарості очерету (відео)

На Південному Бузі пожежа – горять зарості очерету (відео) Шокуюча правда про наркотики та трагічний кінець: на сцені миколаївського театру показали «Вписку»

Шокуюча правда про наркотики та трагічний кінець: на сцені миколаївського театру показали «Вписку» Хвилина мовчання у центрі Миколаєва: пам'ять загиблих вшанували не всі

Хвилина мовчання у центрі Миколаєва: пам'ять загиблих вшанували не всі Офіцер ТЦК за 20 тисяч доларів оформлював «бронь» військовозобов’язаним «під ключ», - ДБР

Офіцер ТЦК за 20 тисяч доларів оформлював «бронь» військовозобов’язаним «під ключ», - ДБР